안녕하세요 대추입니다.

공부를 하다 용어들이 이해가 안되서 매번 구글링 하기 귀찮아 저장용 용어정리 포스트를 하려합니다.

계속 업데이트 될테니 Ctrl + F 하셔서 찾으세요

용어 정리

----------------------------------------------------------------------------------------------------------------------------------------------------------

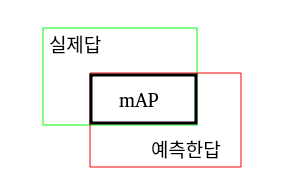

mAP (mean Average Precision, 엠에이피)

하나의 객체(Object)당 1개의 정확도의 평균(AP, Average Precision)을 구한 뒤, 여러 여러 객체 감지(Object Detector)에 대한 평균 값

----------------------------------------------------------------------------------------------------------------------------------------------------------

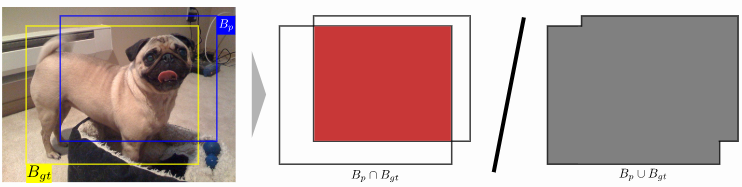

IoU (Intersection over Union, 아이오유)

객체 탐지(Object Detection)를 한 후 모델이 예측한 박스(Bounding Box), Bp와 실제 정답 박스(Ground-truth Bouding Box), Bgt의 영역을 비교하여 겹치는 넓이를 의미한다. (보통 0.5를 넘으면 매치되었다고 한다.)

IoU = 교집합(Intersection) / (실제(Actual) + 예측(Prediction) - 교집합(Intersection))

----------------------------------------------------------------------------------------------------------------------------------------------------------

RoI (Region of Interest, 알오아이)

모델이 이미지에서 관심있어하는 영역, 추출한 영역을 말함

----------------------------------------------------------------------------------------------------------------------------------------------------------

loss (로스)

MSE, RMSE등으로 나타내며 쉽게말해 대입 결과와 실제 정답과의 간격, 차이를 줄이는 것을 의미

(학습 그래프에서 loss 값이 내려갈수록 간격이 줄어들어 좋아지는 것을 의미, 이게 상승한다면 그 이상 학습하는 것이 의미가 없음)

----------------------------------------------------------------------------------------------------------------------------------------------------------

epoch (에포크)

학습하는 횟수를 의미

(ex : epoch=5, 5번 한다는 의미)

----------------------------------------------------------------------------------------------------------------------------------------------------------

Channel (채널)

쉽게 햄버거로 예를 들면 빵, 야채처럼 각각 한 층을 의미

(ex : 100px, 100px, 컬러 이미지의 채널을 표현할때 (100, 100, 3)과 같이 표기, 3은 RGB라 3이며 흑백은 1)

----------------------------------------------------------------------------------------------------------------------------------------------------------

Convolution Layer (합성곱층)

이미지 데이터에서 특징값을 찾아내는 레이어

(1이 써있는 이미지를 떠올리고 가운데 부분만 숫자가 있고 좌우에는 0으로 채워져있는 배열의 모습을 상상)

Conv layer 연산

⎡1 0 1⎤

⎢0 1 0⎥

⎣1 0 1⎦

[101010101]

----------------------------------------------------------------------------------------------------------------------------------------------------------

Pooling Layer (풀링층)

Convolution 레이어의 결과값으로 Feature Map이라는 결과가 나오는데 그것의 크기를 줄기거나 특정 데이터를 강조하는 역할

Pooling 연산중 maxpool의 모습

----------------------------------------------------------------------------------------------------------------------------------------------------------

Padding Layer (패딩층)

Conv 레이어의 결과로 나온 배열을 그대로 둘지, 늘릴지를 조절하는 층

(0이 padding 된 것)

----------------------------------------------------------------------------------------------------------------------------------------------------------

Dropout (드랍아웃)

학습을 반복할때 했던 걸로 하면 train 세트에만 맞는 모델로 되는 과적합(Overfitting) 현상이 발생, 이것을 줄이기 위해 Dropout이라는 것을 사용해 랜덤으로 버리는 것을 의미

(ex : Dropout(0.2)는 입력데이터에서 랜덤으로 20%를 버린다는 의미)

----------------------------------------------------------------------------------------------------------------------------------------------------------

Activation Function (활성화 함수)

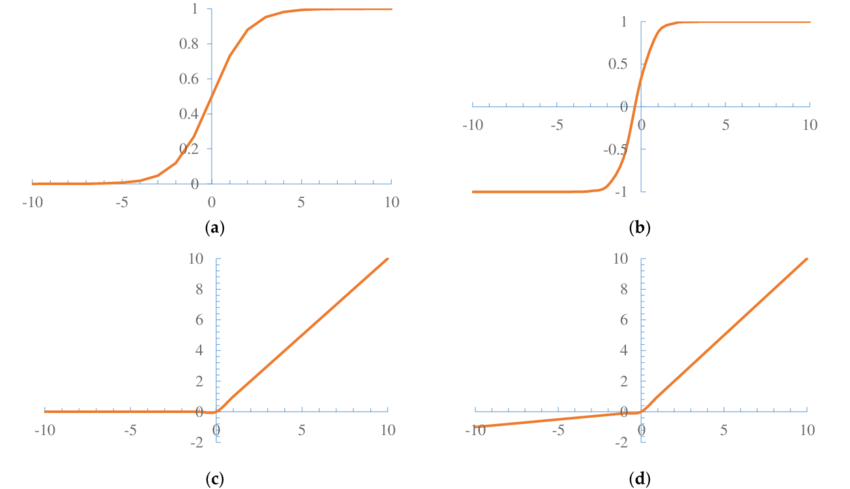

sigmoid, relu가 대표적이며 위에서 설명한 Feature Map을 비선형값으로 바꿔주는 역할

(a) sigmoid (b) Tanh (c) ReLU (d) Leaky ReLU

----------------------------------------------------------------------------------------------------------------------------------------------------------

Ground Truth (실제 정답 값)

모델이 예측한 값이아닌 실제 정답 값을 의미

(Ground truth location : 객체의 실체 위치, Ground truth bounding box : 객체를 그린 박스의 실제 위치)

----------------------------------------------------------------------------------------------------------------------------------------------------------

'공부하는 중~~ > 인공지능' 카테고리의 다른 글

| [Ubuntu 20.04] 아나콘다(Anaconda)를 사용해 가상환경 다루기 (0) | 2020.12.01 |

|---|---|

| [CNN] R-CNN의 업그레이드, Fast R-CNN (0) | 2020.10.29 |

| [CNN] CNN, R-CNN? 쉽게 알아보자 (0) | 2020.10.26 |

| [RetinaNet] RetinaNet 개념 정리 (추가중) (0) | 2020.10.23 |

| [Colab] AI 공부하는데 그래픽카드가 없어? 걱정하지마 colab이 있잖아!! (0) | 2020.10.16 |

댓글